背 景

为什么升级到25G以太网络?

过去的一年里,我们可以看到很多互联网数据中心的服务器接入已经从10G以太网升级到25G以太网,大家为什么要升级到25G以太网呢?

• 支撑高性能业务:主要配合业务的快速扩张和应用系统性能的提升,例如基于AI、大数据的互联网应用推动业务流量成倍增长;

• 支撑业务突发:存在业务突发的应用热点使得业务方需要基础架构做到全力支撑;

匹配服务器性能的升级:服务器CPU及存储I/O的性能升级,使得每台服务器网络吞吐性能增加,10G组网无法满足带宽需求;

• 单比特成本降低:对于公有云类业务,25G以太网实现网络单比特成本下降,降低运营成本;

技术红利:新一代的25G以太网交换机芯片,提供了丰富的技术特性,如Telemetry、RDMA(Remote Direct Memory Access,远程直接数据存取)等,大大提升了基础网络运维的效率,降低了成本。

在互联网数据中心中,25G以太网相比10G以太网在组网架构层面有什么变化?接下来就让我们一起来了解25G组网架构。

是什么决定了25G组网架构?

在部署建设25G数据中心网络时,为更好地进行产品选型和架构方案的确定,我们可以把影响因素归纳到两个方面:

• 服务器规模:指预期单集群中服务器的数量;

• 业务应用需求:指不同业务类型对网络收敛比、服务器单上联/双上联等方面的要求。

最常见的网络架构模型为二级网络架构和三级网络架构,下面将为大家分析这两种架构与服务器规模、适用业务应用需求之间的对应关系。

25G网络架构设计方案

二级网络架构

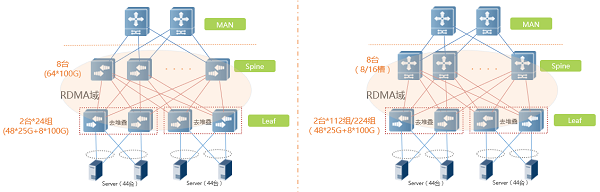

▲图1:二级网络架构拓扑图

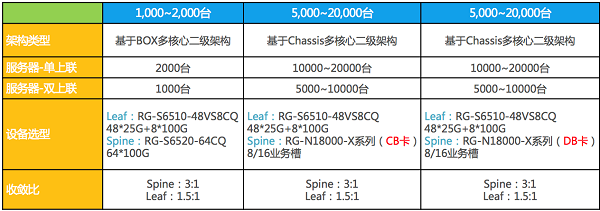

如上图1中的两种二级网络架构拓扑图,我们针对服务器单上联/双上联方式、规模、设备选型、收敛比等方面进行分析如下:

▲表1:二级网络架构对比表

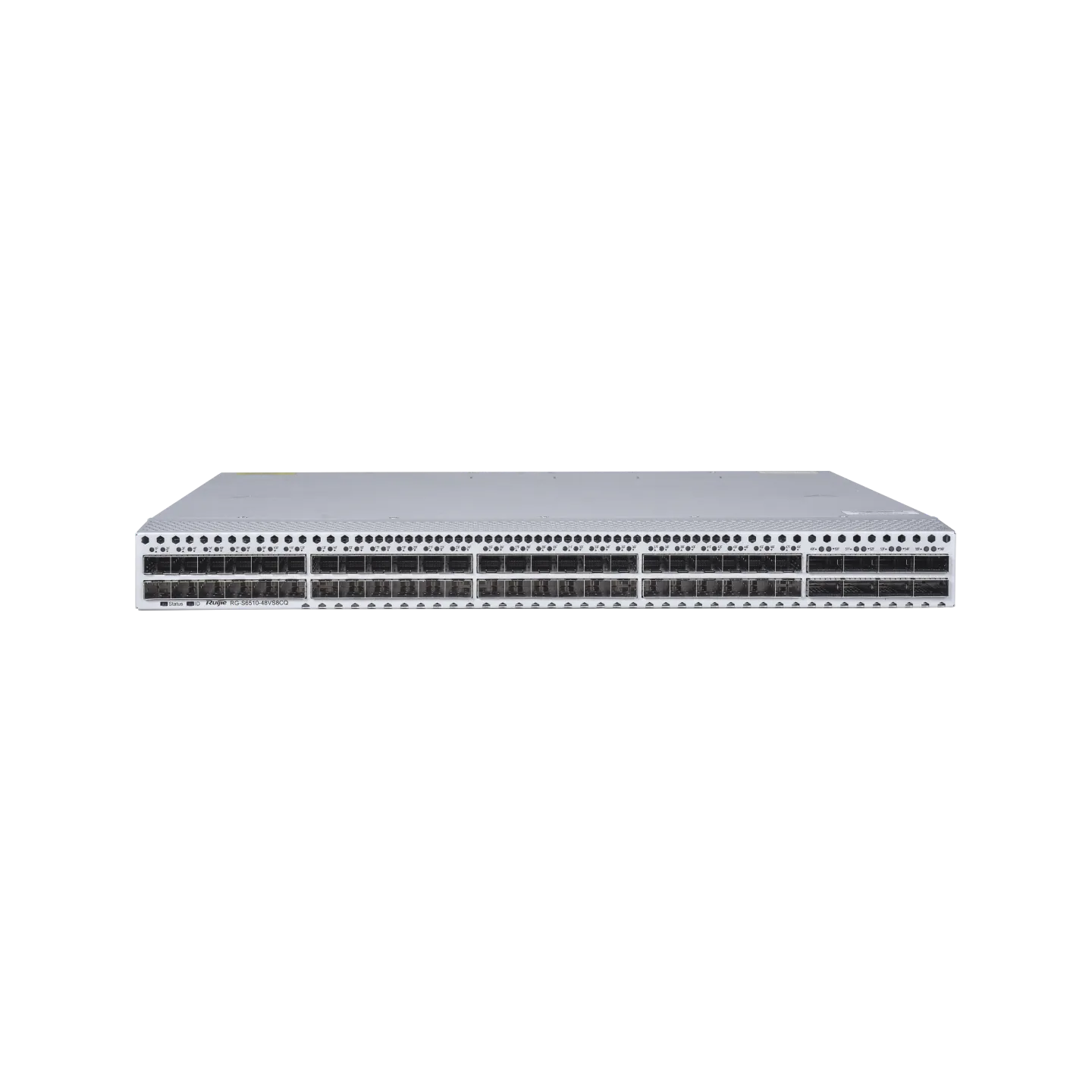

当单集群服务器规模在1000~2000台时,可以采用基于盒式(BOX)多核心二级架构即可满足需求,由于该架构中采用同系列单芯片交换机方案,对于PFC(Priority-based Flow Control,基于优先级的流量控制)+ECN(Explicit Congestion Notification,显式拥塞通知)+MMU(Memory Management Unit,内存管理单元)管理,芯片水线设置一致性高、协调性好,同时转发时延低、吞吐率高,整网可部署RDMA业务和网络可视化方案。

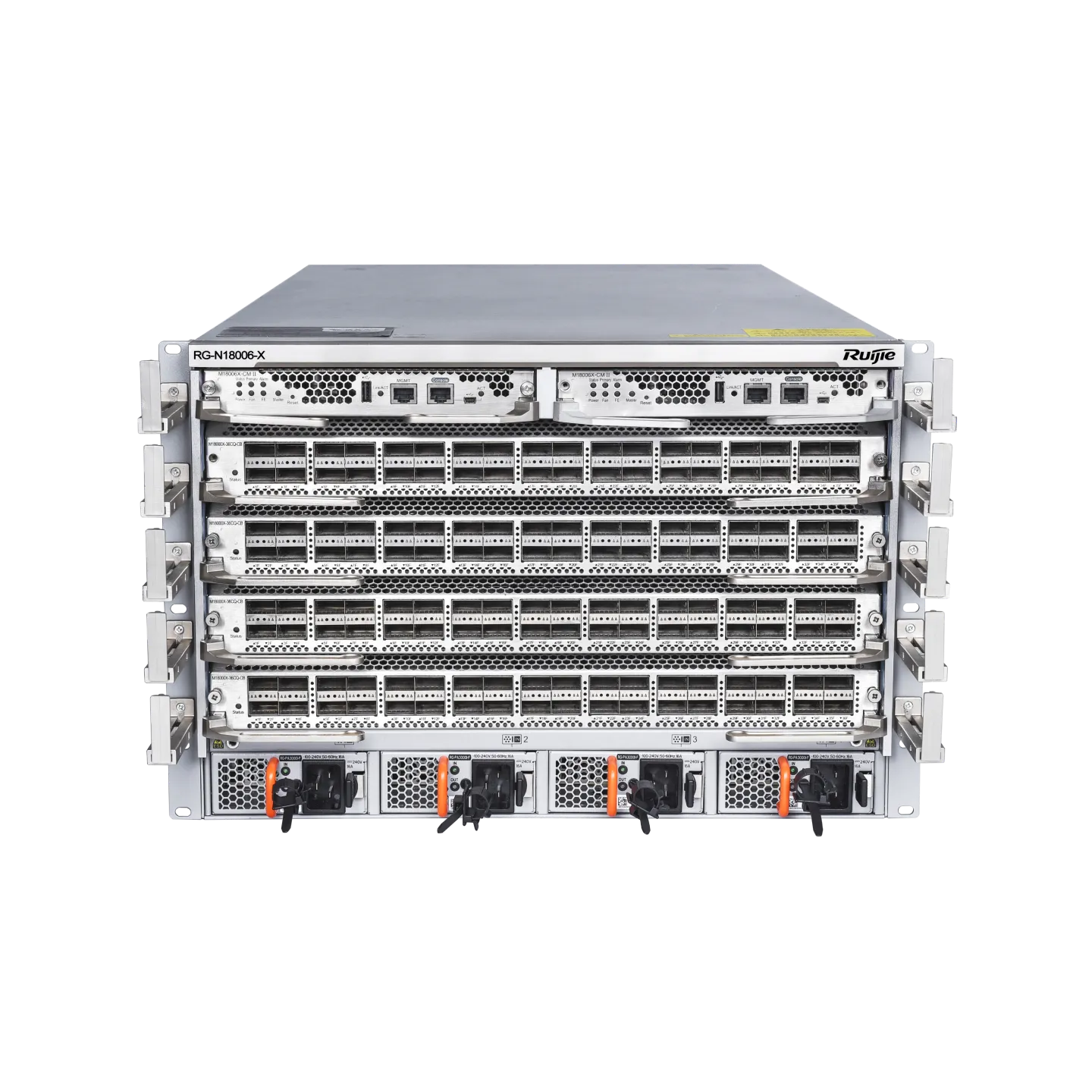

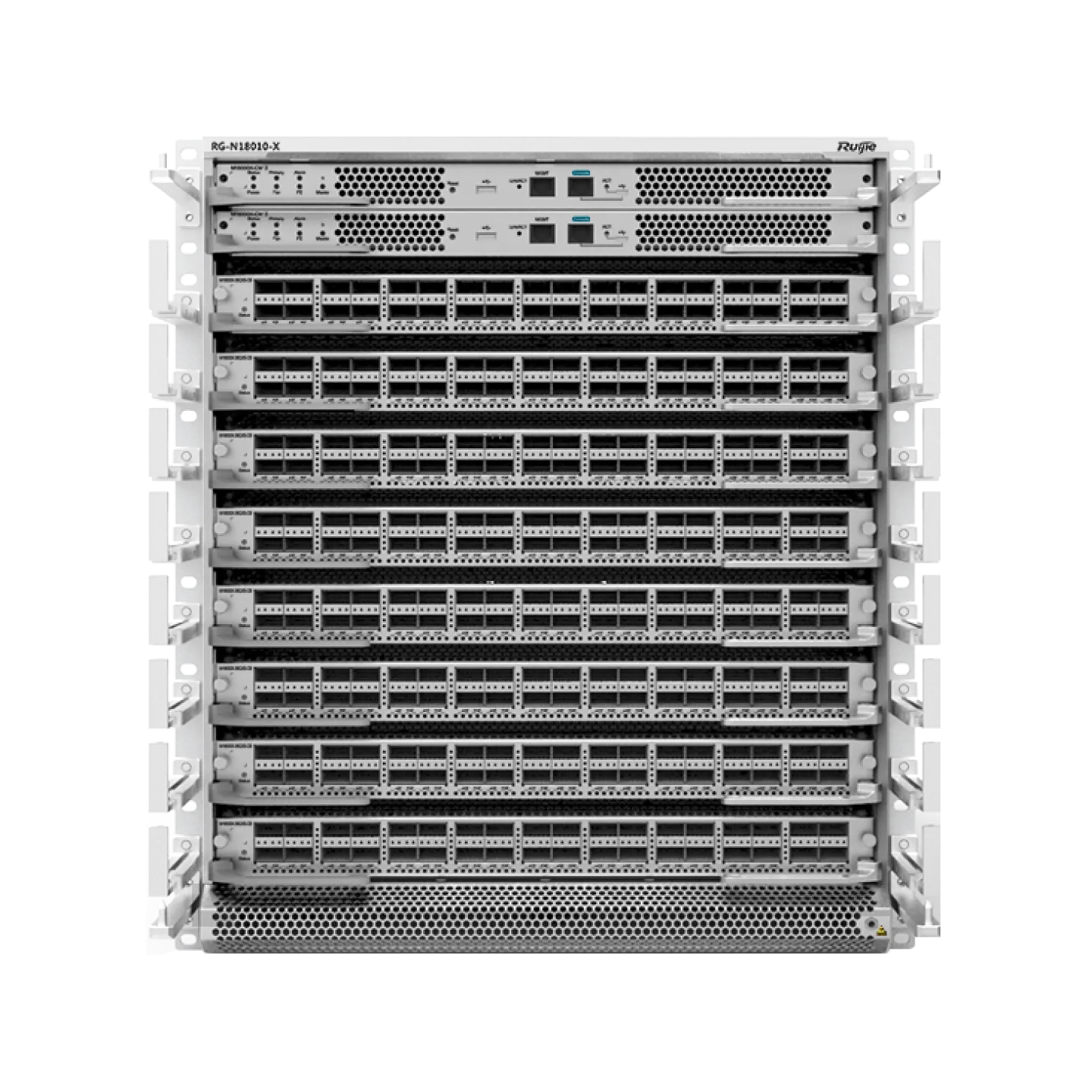

当单集群服务器规模在5000~20000台时,可以采用基于Chassis多核心二级架构,该架构Spine层核心设备有两种类型核心板卡可以选择,分别如下:

• CB类板卡,满足业务常出现多打一的场景,通过大缓存机制有效减少多打一场景下的丢包;

• DB类板卡,满足业务对于RDMA组网和网络可视化要求较高场景,同时该架构继承了基于BOX多核心二级架构的优势。

在二级组网架构中,我们可以基于单集群服务器规模和业务需求决定采用哪种架构,在组网中路由协议部分, 在Spine-Leaf之间可采用EBGP(External Border Gateway Protocol,外部边界网关协议)协议,所有Leaf设备部署相同AS 号(Autonomous System number,自治域系统号),Spine层接收Leaf层路由后进行AS号替换,解决EBGP水平分割问题。当业务需要服务器双上联时,建议采用去堆叠方案进行Leaf层部署,具体细节详见《【第六期】如何实现数据中心网络架构“去”堆叠》。

三级网络架构

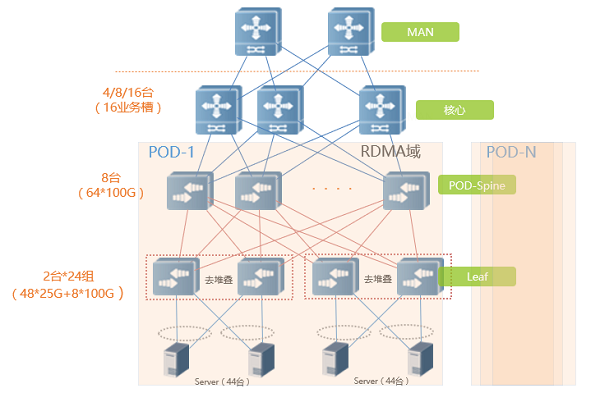

▲图2:三级架构拓扑图

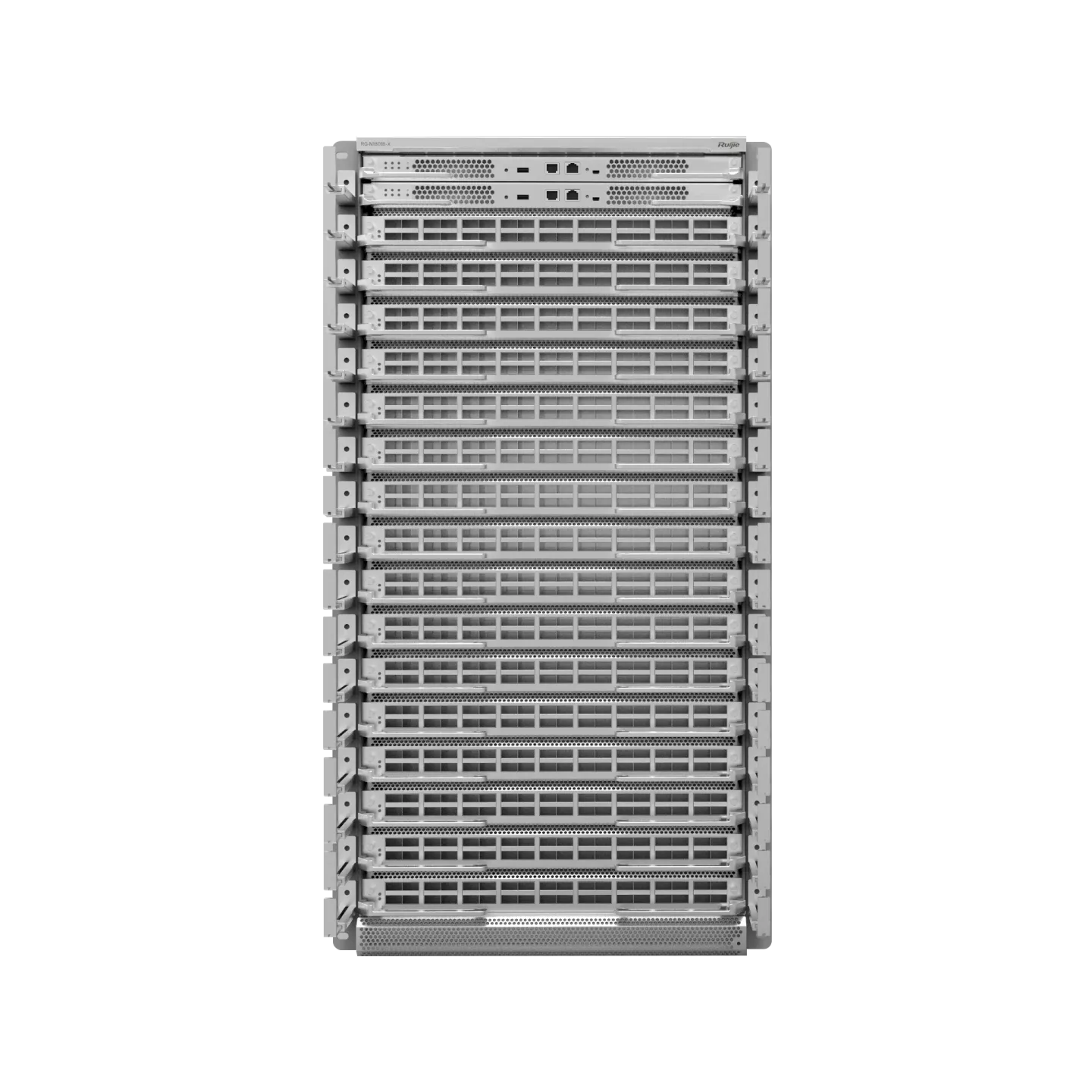

对于单集群服务器规模超过2万台的超大型数据中心,Spine+Leaf的二级组网已经不能满足需求,且扩展性也变差。这时建议采用基于POD(Point Of Delivery,数据中心最小单元)横向扩展(Scale-out)的三级架构。

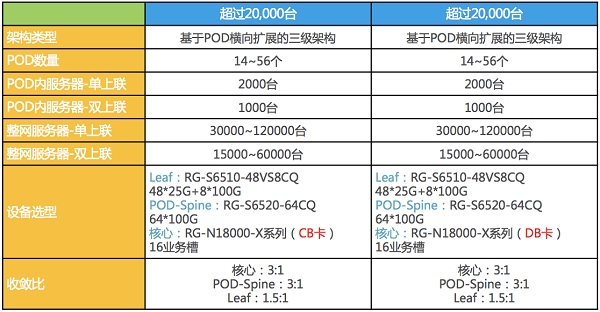

如上图2,每个POD内是Spine+Leaf的二级组网,服务器数量和网络设备数量标准化固定,多个POD之间再通过核心设备进行互联,从而实现更大规模的组网,解决灵活扩展的问题。我们通过POD数量、服务器规模、设备选型和收敛比来进行呈现如下表2:

▲表2:三级架构对比表

在三级组网架构中,同样也是相同的架构下两种设备选型,其中POD内部即为标准的Spine+Leaf二级架构,设备选型一致。在核心层进行区分选择,该选择如二级架构中的Chassis(CB类板卡)多核心二级架构和Chassis(DB类板卡)多核心二级架构的选择,在此不再赘述。但这里需要注意当业务需求部署RDMA业务时,建议将RDMA域的部署范围控制在POD内部,因为更大规模的RDMA部署,PFC和ECN报文的控制难度将极具增大,同时拥塞反压影响更为严重。如果要规划更大规模的数据中心,在单集群实现超过10万台服务器,就需要升级Spine层交换机设备,采用可提供128口100G的BOX设备,这样POD内可实现服务器规模翻倍。

下一代数据中心架构展望

据IDC(International Data Corporation,国际数据公司)预测,2025年数据中心要处理的数据量将达到175ZB,是2018年的5倍之多,且中国增长最为迅速,从2018年的7.6ZB预计到2025年增长到48.6ZB。在快速增长的数据面前,基础网络需要多方面的努力,例如从网络带宽的迭代升级和1:1网络收敛比的IP CLOS架构上进行改进,那么下一代组网架构在IP CLOS网络架构中是否还会采用Chassis设备,以及未来服务器接入将演进升级到什么形态以满足业务需求分析将在下一篇文章详细解读。

本期作者:王磊

锐捷网络互联网系统部行业咨询

往期精彩回顾

- 【第一期】浅谈物联网技术之通信协议的纷争

- 【第二期】如何通过网络遥测(Network Telemetry)技术实现精细化网络运维?

- 【第三期】畅谈数据中心网络运维自动化

- 【第四期】基于Rogue AP反制的无线安全技术探讨

- 【第五期】流量可视化之ERSPAN的前世今生

- 【第六期】如何实现数据中心网络架构“去”堆叠

- 【第七期】运维可视化之INT功能详解

- 【第八期】浅析RDMA网络下MMU水线设置

- 【第九期】第七代无线技术802.11ax详解

- 【第十期】数据中心自动化运维技术探索之交换机零配置上线

- 【第十一期】 浅谈数据中心100G光模块

- 【第十二期】数据中心网络等价多路径(ECMP)技术应用研究

- 【第十三期】如何为RDMA构建无损网络

- 【第十四期】基于EVPN的分布式VXLAN实现方案

- 【第十五期】数据中心自动化运维技术探索之NETCONF

- 【第十六期】一文读懂网络界新贵Segment Routing技术化繁为简的奥秘

- 【第十七期】浅谈UWB(超宽带)室内定位技术

- 【第十八期】PoE以太网供电技术详解

- 【第十九期】机框式核心交换机硬件架构演进

- 【第二十期】 IPv6基础篇(上)——地址与报文格式

- 【第二十一期】IPv6系列基础篇(下)——邻居发现协议NDP

- 【第二十二期】IPv6系列安全篇——SAVI技术解析

- 【第二十三期】IPv6系列安全篇——园区网IPv6的接入安全策略

- 【第二十四期】Wi-Fi 6真的很“6”(概述篇)——不只是更高的传输速率

- 【第二十五期】 Wi-Fi 6真的很“6”(技术篇) ——前方高能,小白慎入

- 【第二十六期】IPv6系列应用篇——数据中心IPv4/IPv6双栈架构探讨

- 【第二十七期】你不可忽视的园区网ARP安全防护

- 【第二十八期】企业办公网接入认证技术详解

相关推荐:

更多技术博文

-

解密DeepSeek-V3推理网络:MoE架构如何重构低时延、高吞吐需求?

解密DeepSeek-V3推理网络:MoE架构如何重构低时延、高吞吐需求?DeepSeek-V3发布推动分布式推理网络架构升级,MoE模型引入大规模专家并行通信,推理流量特征显著变化,Decode阶段对网络时度敏感。网络需保障低时延与高吞吐,通过端网协同负载均衡与拥塞控制技术优化性能。高效运维实现故障快速定位与业务高可用,单轨双平面与Shuffle多平面组网方案在低成本下满足高性能推理需求,为大规模MoE模型部署提供核心网络支撑。

-

#交换机

-

-

高密场景无线网络新解法:锐捷Wi-Fi 7 AP 与 龙伯透镜天线正式成团

高密场景无线网络新解法:锐捷Wi-Fi 7 AP 与 龙伯透镜天线正式成团锐捷网络在中国国际大学生创新大赛(2025)总决赛推出旗舰Wi-Fi 7无线AP RG-AP9520-RDX及龙伯透镜天线组合,针对高密场景实现零卡顿、低时延和高并发网络体验。该方案通过多档赋形天线和智能无线技术,有效解决干扰与覆盖问题,适用于场馆、办公等高密度环境,提供稳定可靠的无线网络解决方案。

-

#无线网

-

#Wi-Fi 7

-

#无线

-

#放装式AP

-

-

打造“一云多用”的算力服务平台:锐捷高职教一朵云2.0解决方案发布

打造“一云多用”的算力服务平台:锐捷高职教一朵云2.0解决方案发布锐捷高职教一朵云2.0解决方案帮助学校构建统一云桌面算力平台,支持教学、实训、科研和AI等全场景应用,实现一云多用。通过资源池化和智能调度,提升资源利用效率,降低运维成本,覆盖公共机房、专业实训、教师办公及AI教学等多场景需求,助力教育信息化从分散走向融合,推动规模化与个性化培养结合。

-

#云桌面

-

#高职教

-

-

医院无线升级必看:“全院零漫游”六大谜题全解析

医院无线升级必看:“全院零漫游”六大谜题全解析锐捷网络的全院零漫游方案是新一代医疗无线解决方案,专为智慧医院设计,通过零漫游主机和天线入室技术实现全院覆盖和移动零漫游体验。方案支持业务扩展全适配,优化运维管理,确保内外网物理隔离安全,并便捷部署物联网应用,帮助医院提升网络性能,支持旧设备利旧升级,降低成本。

-

#医疗

-

#医院网络

-

#无线

-